Macro | 💽 Stati della computazione/1 💽

Una serie su chip, AI stack, infrastrutture tecnologiche, geopolitica, clima.

Affermare che viviamo nell’ “era digitale” è un luogo comune. Meno comune è ricordare come ciò che chiamiamo “era digitale” si regga in realtà su infrastrutture materiali che operano tramite computazione, ovvero per calcoli. Ancora meno ovvio è sottolineare come la complessità di tali sistemi, e dei relativi calcoli, non solo stia aumentando ma, come vedremo, per molti versi stia cambiando pelle. È chiamata ad affrontare problemi – di natura tecnica, politica, economica, etica, ecologica – inauditi. Problemi che aprono le porte a interrogativi che riguardano il futuro di intere società e modi di vivere.

Per questa ragione ritengo utile mettere insieme una specie di riepilogo, a scopo divulgativo, di quello che è lo “stato della computazione” contemporanea. Lo farò in più “puntate”, pensate per essere pubblicate sulla mia newsletter, Macro, e su quella di Stefano Feltri, Appunti. Questa è la prima: consideratela una sorta di introduzione.

La computazione è un’infrastruttura

Suppongo che se chiedessimo a cento italiani estratti a sorte di indicarci un computer, la stragrande maggioranza ci mostrerebbe un desktop o un laptop. Qualcuno probabilmente uno smartphone. Una percentuale minore citerebbe una console da videogiochi. Pochissimi un’automobile o un elettrodomestico.

Come dimostra mia madre ogni volta che, consultando il meteo di Google, esclama: “domani piove, lo dice il cellulare”, la maggioranza di noi continua a concepire la computazione come una specie di magia che avviene soltanto all’interno degli oggetti tecnologici in suo possesso ed è ad essi indissolubilmente legata. È un riflesso comprensibile. In fondo la computazione è entrata nelle nostre vite per prima cosa sotto forma di oggetti personali. Dopo i primi decenni di vita, in cui i computer occupavano intere stanze, negli anni Settanta la computazione ha cominciato a divenire un “oggetto di consumo”, una merce materiale. Si entrava in un negozio e se ne usciva con un personal computer. Un oggetto. Un po’ più tardi se ne usciva con scatole piene di manuali e di cd per installare software. Altri oggetti. Infine, ancora più in là, se ne usciva con Playstation, iPod, iPhone. Sempre e comunque oggetti.

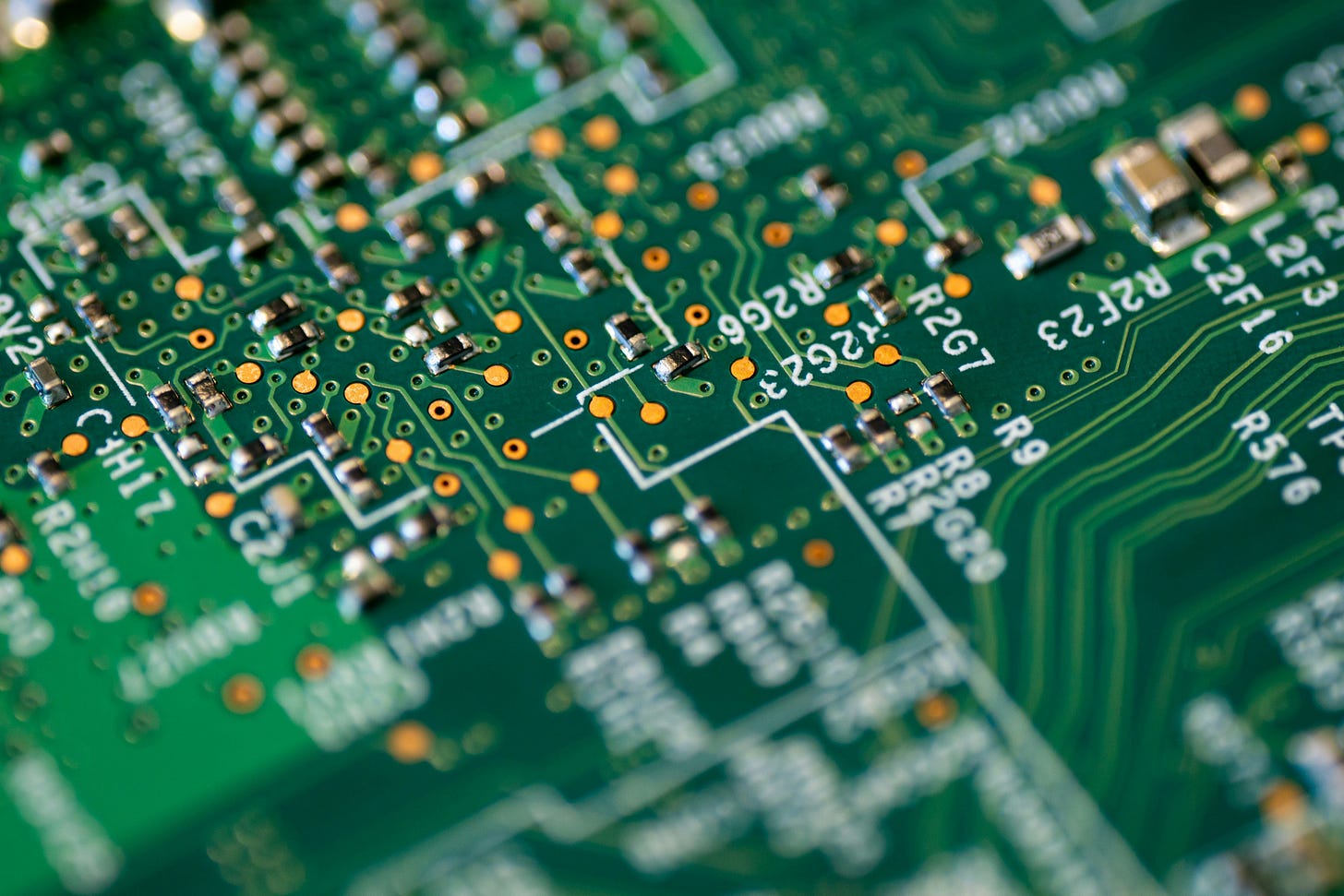

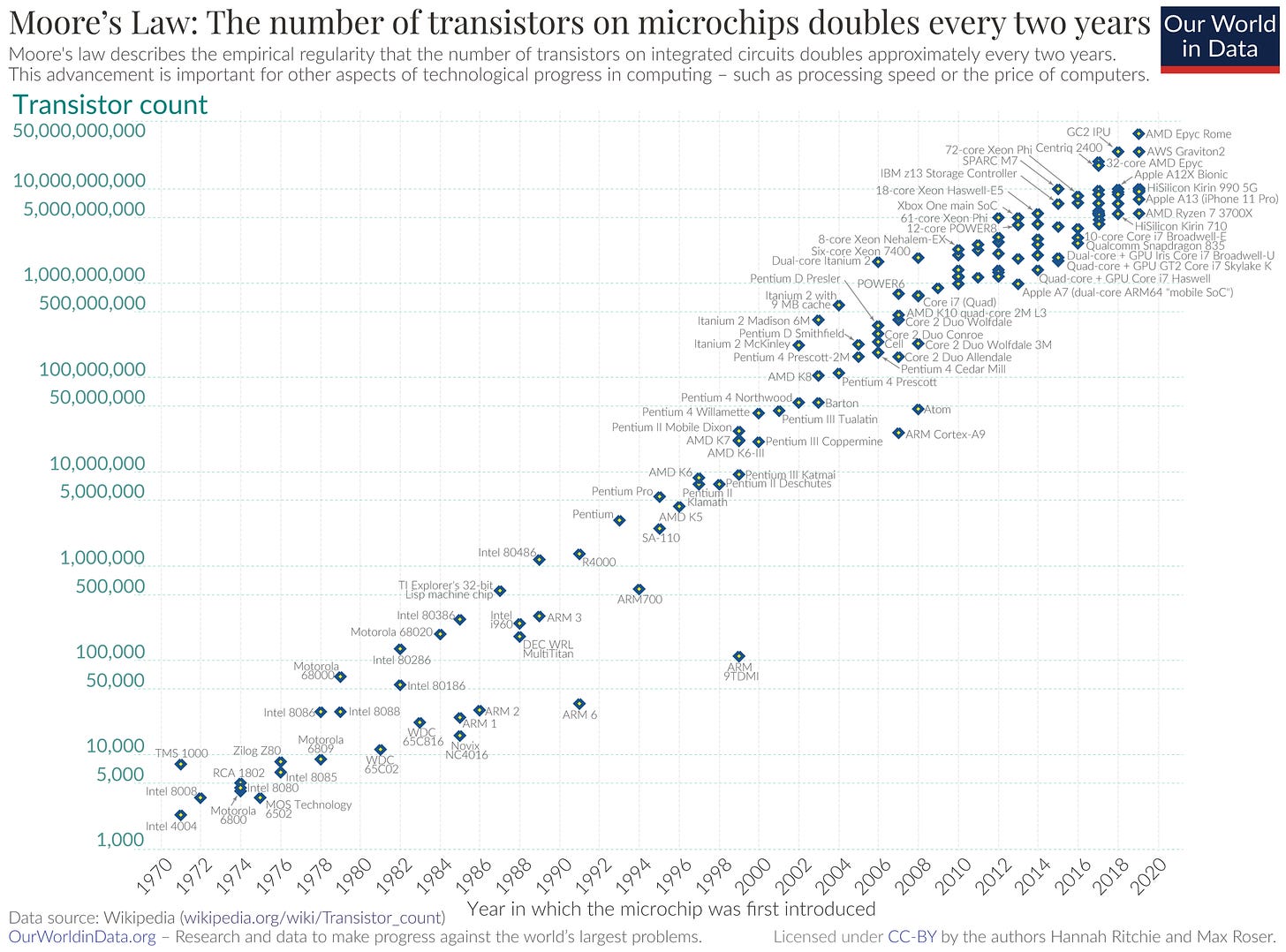

In parallelo a questa storia, ne scorrevano però già altre. Una aveva a che fare con le dimensioni (minori), le capacità (maggiori) e i costi (più bassi) di quegli oggetti. Essa dipendeva dal processo, di per sé strabiliante, di miniaturizzazione dei transistor (i neuroni artificiali della computazione) contenuti nei chip. Un’evoluzione che ha fatto sì che la CPU del computer su cui scrivo contenga decine di miliardi di transistor nello spazio di pochi centimetri. Se volete un metro di paragone: nel primo microprocessore – l’Intel 4004 del 1971 – i transistor erano 2,300. Tuttavia, come racconteremo tra poco, questo processo di miniaturizzazione è oggi prossimo al suo limite fisico. E non solo, come vedremo in una successiva puntata, l’industria dei chip è, ormai da anni, al centro di una delle principali contese geopolitiche del nostro tempo.

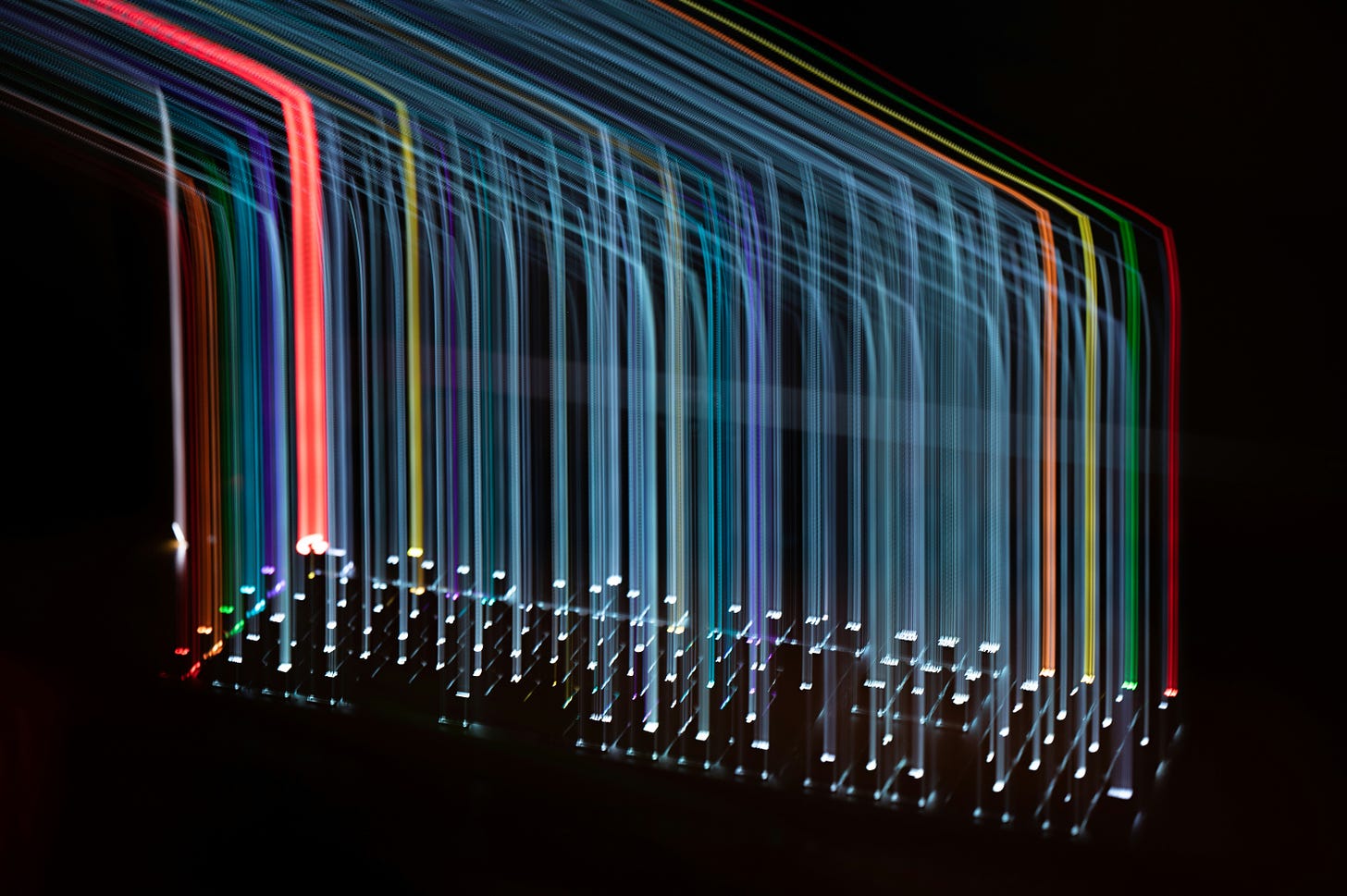

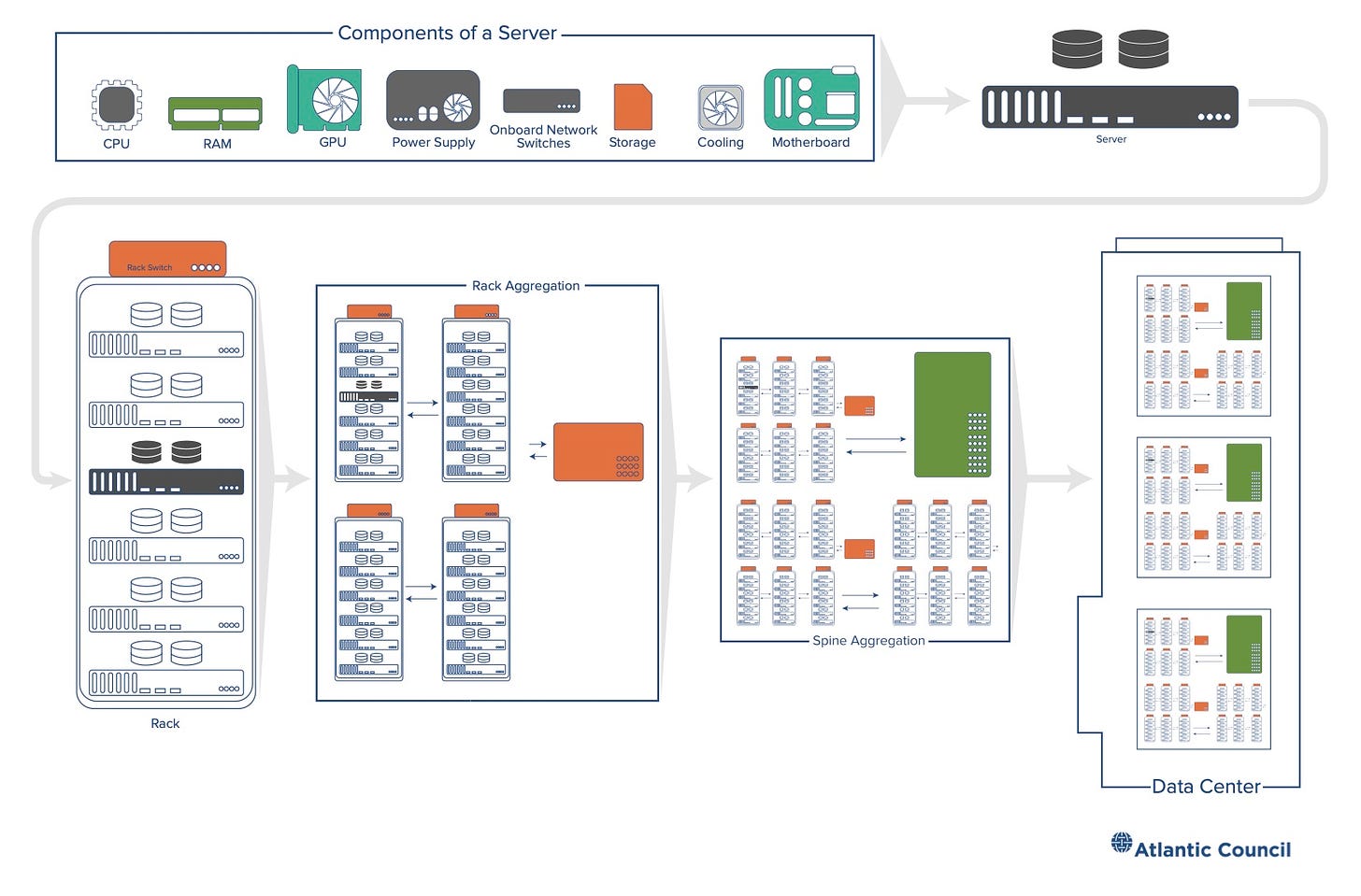

Un’altra storia – comunque dipendente dalla precedente – aveva a che fare con la trasformazione della computazione da un fenomeno che avveniva principalmente all’interno di oggetti di fronte a noi, in un fenomeno che si svolgeva in luoghi distanti per esserci poi venduto sotto forma di servizi. Questa storia inizia – già negli anni Cinquanta – con i primi esperimenti di interconnessione dei computer in reti. Col tempo queste reti si inspessiscono e infittiscono. Cominciano a generare e immagazzinare informazione che non risiede più fisicamente nell’hardware di chi ne fa uso ma si trova altrove, dentro computer specializzati chiamati server, e viene distribuita attraverso cavi, fibre e segnali. Man mano che questo tipo di computazione avanza, e i servizi che offre divengono sempre più appariscenti nelle nostre vite, i server si fanno più potenti e numerosi, al punto che, per contenerli, diviene necessario costruire delle vere e proprie cattedrali della computazione: i famosi data center.

Questa seconda evoluzione è la ragione per cui, negli ultimi quindici anni, siamo divenuti dipendenti da social media, app, piattaforme; nonché il motivo per cui sentiamo quotidianamente parlare di big data, cyber-security e intelligenza artificiale. Benché spesso si presenti questo sviluppo con un termine etereo come cloud computing, o semplicemente cloud (nuvola), la realtà è che questa “nuvola” non ha nulla di impalpabile. Tutt’altro. Essa può fluttuare sopra le nostre teste solo grazie a una gigantesca infrastruttura materiale. O meglio, grazie a uno stack (pila) di infrastrutture che, tramite una serie di standard, connette, coordina e integra diversi livelli e protocolli di computazione.

Micro e macro

Tutto ciò che di rilevante accade oggi nell’universo della computazione accade nelle due principali dimensioni dello stack: la scala microscopica dei chip e dei transistor e quella macroscopica delle infrastrutture di accumulazione, elaborazione e distribuzione dei dati. Le due scale sono interdipendenti, nel senso che dalle direzioni, e dai ritmi, dello sviluppo di una dipende l’altra e viceversa. I problemi dell’una diventano spesso dell’altra e così via.

Questa interdipendenza esisteva già da parecchio ma negli ultimi dieci anni si è ulteriormente approfondita in virtù della crescita del settore dell’intelligenza artificiale che, più di ogni altro, rappresenta un punto di sutura tra le due dimensioni.

La peculiare tipologia di calcoli necessaria allo sviluppo dell’intelligenza artificiale non solo sta mutando l’infrastruttura della computazione ma sta anche esasperando alcune sue criticità. Come accennavo all’inizio, tali criticità sono di diversa natura, così come di diversa natura sono le loro conseguenze sul mondo in cui viviamo e vivremo.

Alla base dello stack dell’AI – le sue fondamenta, per così dire – c’è, come detto, il microchip, la particella elementare della computazione, dal cui sviluppo dipende da sempre la progressione della potenza di calcolo a nostra disposizione. Tale progressione è stata osservata, già agli esordi della tecnologia, da uno dei suoi pionieri: Gordon Moore. Il quale, nel 1965, notò che “la complessità di un chip, misurata ad esempio tramite il numero di transistor per chip, raddoppia ogni 18 mesi”. Questa osservazione, in seguito leggermente rivista (i mesi diventarono 24), è passata alla storia come “legge di Moore”.

La “legge di Moore” tuttavia non è affatto una “legge”, nel senso in cui si intende il termine in campo matematico o fisico. La parola chiave in questo caso è “osservazione”. Nel 1965 Moore fece caso a una tendenza iniziale relativa all’aumento del numero dei transistor e si limitò a ipotizzare che tale tendenza sarebbe potuta durare per un certo periodo di tempo. La sua osservazione non aveva rigore scientifico né pretendeva di averlo. Tuttavia, anche grazie agli sforzi compiuti da scienziati e ingegneri per rispettarla, la “legge di Moore” è sopravvissuta per quasi mezzo secolo, garantendoci un’esplosione di potere di computazione a costi sempre più contenuti. È grazie alla validità della predizione di Moore se l’informatica si è (finora) presentata come un fenomeno sempre più inclusivo e se – come raccontavo poc’anzi – la computazione è entrata nelle nostre vite sotto forma di oggetti sempre più piccoli ed economici.

La “legge di Moore” non è purtroppo destinata a durare per sempre. I transistor possono essere rimpiccioliti solo fino a un certo punto. Dopodiché le leggi della fisica classica lasciano il posto a quelle della meccanica quantistica che rendono impossibile controllare i flussi di elettroni a fini computativi. Già oggi i transistor, e i fili che li connettono, sono misurati su scala atomica, poco più larghi di un filamento di DNA umano (2,5 nanometri). Sebbene resti ancora margine per rimpicciolirli, i progressi nella miniaturizzazione dei transistor diventano ogni anno più lenti e costosi e, in ogni caso, tra non molto dovranno arrendersi, come detto, di fronte a limiti fisici al momento invalicabili. Possiamo insomma discutere a lungo (e nell’industria dei chip lo si fa di continuo) se la legge di Moore sia ancora viva o se invece sia già morta (come suggeriscono alcuni indicatori) ma quel che è certo è che ci avviciniamo al suo capezzale.

La “fine” della legge di Moore non solo sta spingendo alla ricerca di strumenti e sistemi computativi alternativi (ne parleremo in un prossimo episodio) ma sta portando all’estremo la complessità tecnica inerente alla progettazione e alla manifattura dei microchip, con effetti soprattutto economici. Il risultato è che il settore è oggi piagato da rendimenti decrescenti in termini di potere di computazione e da una ipertrofia dei costi che coinvolge l’intera catena del valore: macchinari di produzione da 300 milioni di dollari a pezzo, impianti che costano 12-20 miliardi per una singola fabbrica, ingegneri con costi e tempi di formazione elevatissimi e così via.

Tutto ciò si traduce nel fatto che, per esempio, lo sviluppo di Blackwell, la nuova architettura per GPU di Nvidia, ha richiesto all’azienda di Santa Clara un investimento di quasi 10 miliardi, per un prodotto che verrà immesso sul mercato a un prezzo che dovrebbe oscillare, a seconda della configurazione, tra i 30 e i 70mila dollari per esemplare. Cifre simili per un singolo pezzo di hardware sono una netta inversione rispetto alla tendenza a diventare più economica e personale che aveva contrassegnato la precedente fase della computazione. E infatti le GPU di Nvidia non sono un prodotto destinato a semplici consumatori, ma sono, a tutti gli effetti, un componente industriale altamente specializzato che viene principalmente utilizzato – con ordinazioni da decine di migliaia di pezzi al costo di centinaia di milioni di dollari – nei data center delle aziende del “big tech” che partecipano alla cosiddetta “corsa alla AI”.

È intorno a questa corsa che oggi la storia “micro” dei chip e dei transistor, incrocia la dimensione “macro” delle infrastrutture della computazione legata all’addestramento dell’intelligenza artificiale. Il risultato di questo incontro è che 1) l’infrastruttura della computazione si sta sovraccaricando di enormi stress energetici ed ecologici e 2) si sta trasformando in un settore in cui la differenza tra perdite e profitti dipende da enormi economie di scala e di potere computazionale che solo una manciata di aziende, dalle tasche profondissime e dal know-how particolarmente vasto, possono raggiungere. Queste aziende sono oggi note come hyperscaler e il loro peso nell’infrastruttura della computazione, AI e non solo, è sempre più una questione con enormi ricadute geopolitiche ed economiche.

E proprio l’aumento della bolletta energetica complessiva dell’infrastruttura dell’AI e le conseguenze, economiche e geopolitiche, della proibitiva barriera di capitali al suo ingresso saranno i temi della prossima puntata.

Se siete nuovi da queste parti, io mi chiamo Cesare Alemanni. Mi interesso di questioni all’intersezione tra economia e geopolitica, tecnologia e cultura. Per Luiss University Press ho pubblicato La signora delle merci. Dalle caravelle ad Amazon, come la logistica governa il mondo (2023) e Il re invisibile. Storia, economia e sconfinato potere del microchip (2024).

bravissimo