Macro | 🌎 Stati della computazione/3 🌏

La geopolitica della computazione: tra semiconduttori e hyperscaler

Bentornati su Macro. Dopo uno stacco dedicato alle elezioni USA, torna “Stati della computazione”, la mini-serie, suddivisa in più pezzi, per approfondire il tema dell’infrastruttura del computing che esce in contemporanea su Macro e su Appunti di Stefano Feltri. Qui la prima e la seconda puntata.

Prima di introdurre il tema di questa settimana, un annuncio. Domani, venerdì 15 novembre alle 18.30, sarò a Palazzo Assolombarda di Milano (via Pantano, 9) per un incontro di Book City dal titolo “Il nuovo petrolio? No di più. Lo sconfinato potere dei microchip”.

A discutere con me ci sarà Federico Ferrazza, direttore dell’edizione italiana di Wired. Spero di incontrarvi numerosi.

Veniamo ora al tema di questa puntata. Ovvero il legame tra computazione, infrastrutture ad esse dedicata e politica internazionale sia di stampo economico/commerciale che militare.

Seppure nello spazio relativamente breve di un articolo, spero di riuscire a restituire un po’ della complessità e della rilevanza della questione.

Buona lettura!

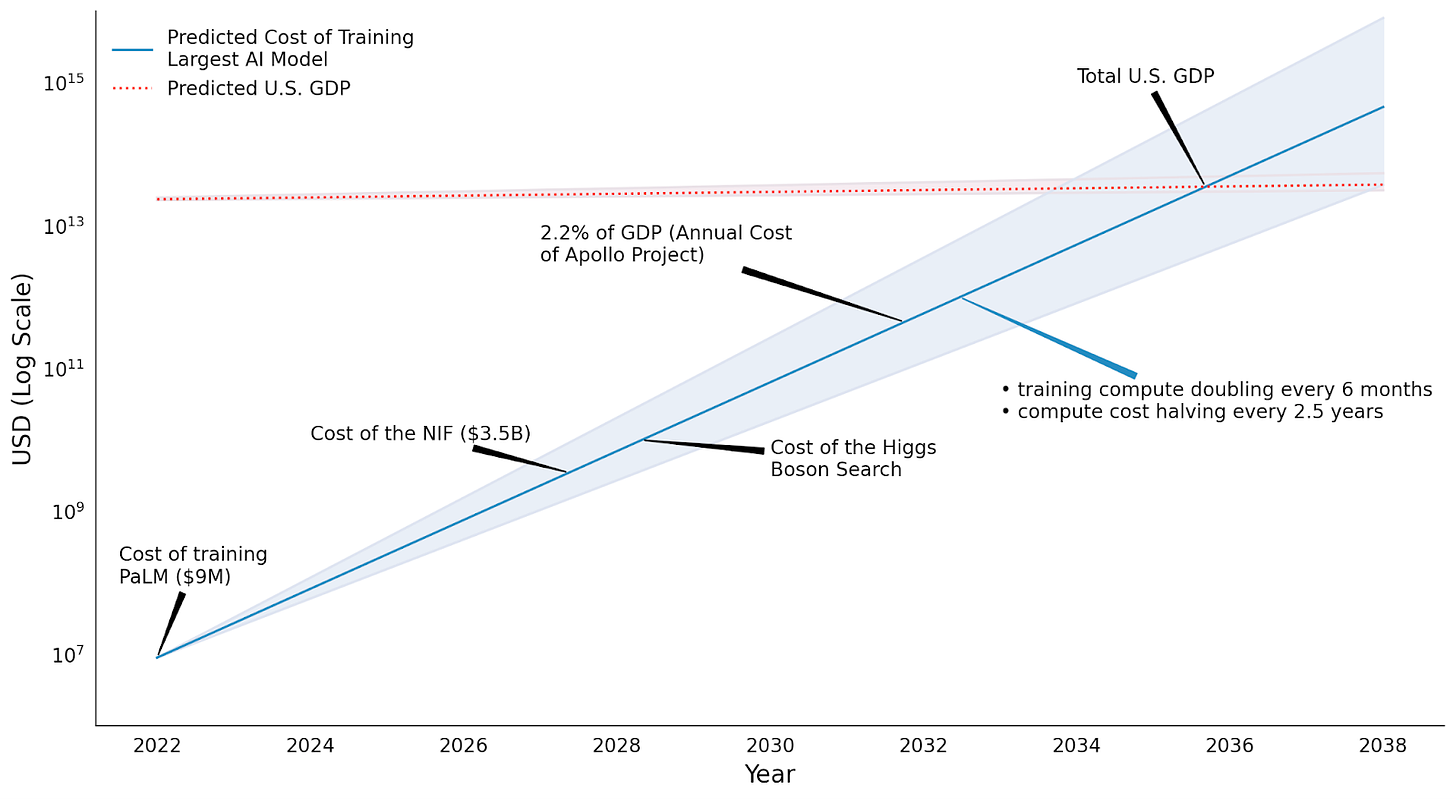

Secondo gli esperti è impossibile prevedere di quanto cresceranno le esigenze computazionali connesse all’AI ma è pressoché certo che, nel medio termine, il loro costo continuerà ad aumentare.

Ciò fa sì che lo sviluppo dell’intelligenza artificiale sia un’operazione al momento accessibile solo a un ristretto grappolo di aziende.

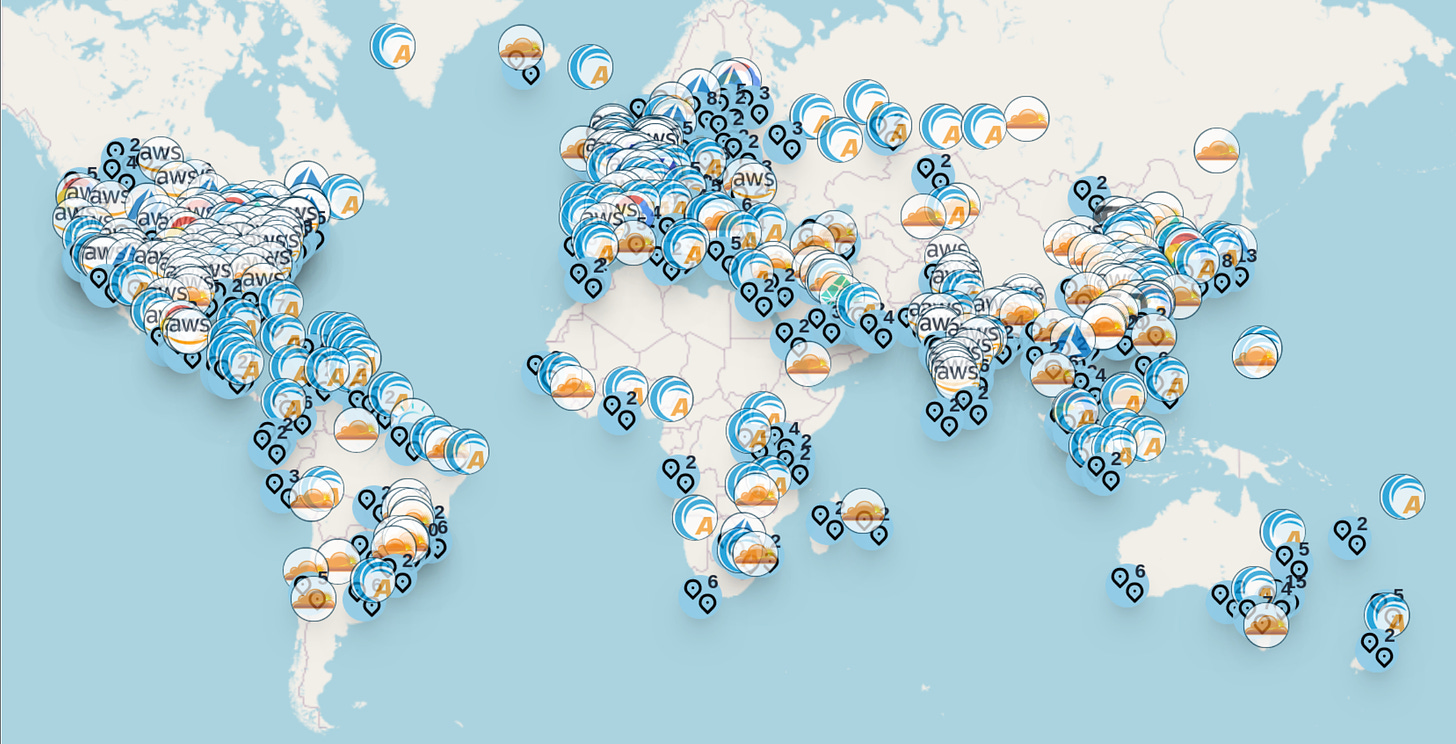

E infatti la maggioranza delle attività di addestramento dell’AI si svolge nelle strutture dei cosiddetti hyperscaler: Oracle, Microsoft Azure, Google Cloud, IBM Cloud e Amazon Web Services per l’emisfero occidentale; Alibaba, Tencent, Huawei per la sfera d’influenza cinese.

A causa della scala dei costi e della potenza di computazione che richiedono i loro modelli, pressoché tutti i più promettenti laboratori indipendenti sull’AI sono finiti sotto l’ombrello di alcuni di questi soggetti: OpenAI con Microsoft, DeepMind e Anthropic con Google, Hugging Face con Amazon etc.

L’accelerazione dell’AI sta in altre parole consolidando l’influenza di alcune aziende che già dominavano il mercato delle infrastrutture della computazione e il precedente ciclo del capitalismo digitale.

Il risultato è che più le AI diventeranno strumenti indispensabili per le nostre società e più esse diventeranno dipendenti – tanto per l’addestramento quanto per l’uso quotidiano – da sistemi di proprietà di una manciata di aziende private.

La dipendenza da pochi fornitori di infrastrutture computazionali può inoltre avere conseguenze significative anche sulla capacità di innovazione.

Quando la maggior parte dei laboratori di ricerca deve fare affidamento sugli hyperscaler per avere accesso alle risorse computazionali, , le dinamiche di sviluppo tecnologico vengono plasmate dagli interessi di questi ultimi. Il che può tradursi in una limitazione nella varietà dell’innovazione.

Il paradosso della computazione

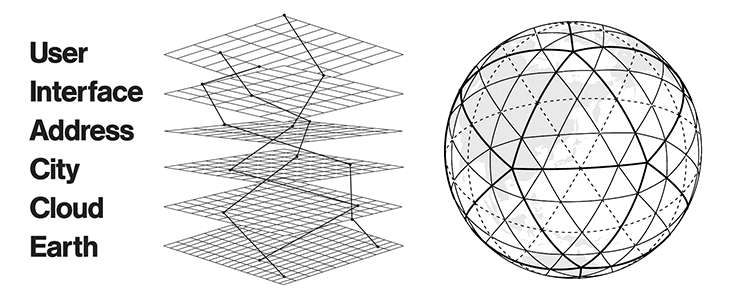

In The Stack, un libro molto ambizioso sull’argomento, il filosofo/informatico Benjamin Bratton, insiste sulla caratteristica inedita, e per certi versi paradossale, delle infrastrutture della computazione.

Ovvero il fatto di essere, per un verso, realtà materiali con confini geografici e giuridici ben precisi e per l’altro produrre servizi ed effetti immateriali che quei confini li attraversano di continuo. E, soprattutto, di determinare, con i loro standard digitali, la cornice tecnica entro cui si svolgono fondamentali istituzioni socio-politiche del mondo fisico, dal mercato alle amministrazioni pubbliche di innumerevoli paesi.

Per capire le problematiche insite nell’influenza geopolitica dello stack della computazione, è necessario rimarcare soprattutto il primo aspetto, cioè quello della materialità dell’infrastruttura.

Perché se è vero che i data center sono centri di trattamento e distribuzione di “valori” immateriali come i dati, è anche vero che il fatto che essi si trovino in un luogo piuttosto che in un altro fa enormi differenze.

Le tecnologie digitali saranno anche il nuovo petrolio ma a differenza del petrolio non è la natura a decidere dove si trovano i loro “giacimenti”, bensì persone, aziende, istituzioni, Stati.

E oggi, perlomeno in Occidente, le uniche aziende in grado di agire da hyperscaler per l’AI rispondono, in ultima istanza, a un solo Stato, gli USA.

Per non dire del fatto che quasi il 90% dei dati prodotti in Occidente – inclusi quelli di governi, amministrazioni pubbliche, persino eserciti – sono immagazzinati in server di proprietà di corporation americane.

Velleità europee

Nell’era del Trump-bis (ma anche prima), per l’Europa la geopolitica della computazione dovrebbe essere causa di profonde riflessioni.

Perché se è vero che oggi sempre più provider di computing in cloud promettono ai loro clienti la “sovranità digitale” – ovvero che i dati saranno gestiti in modo conforme alle leggi del loro Paese di origine e che non verranno condivisi con enti al di fuori di esso – ci si può chiedere che valore abbia una sovranità “fornita” a guisa di servizio e come promessa di “buona condotta”; a fronte di una dipendenza che è invece del tutto effettuale.

In risposta a queste considerazioni, nell’ormai lontano 2019 Francia e Germania hanno lanciato Gaia-X. Descritto dall’allora ministro dell’economia tedesco Peter Altmaier come “qualcosa che somiglia a un Airbus dell’intelligenza artificiale”, Gaia-X rappresentava il tentativo delle due principali economie europee di dotare l’Europa di un “campione continentale” della computazione in cloud.

L’iniziativa di Gaia-X nasceva sulla scorta di una serie di fallimentari progetti nazionali con intenti simili, tra cui spicca il francese Projet Andromède.

A più di cinque anni dal suo lancio e a più di quattro dalla sua messa in moto, Gaia-X non ha ancora prodotto nulla di paragonabile all’ambizione con cui era stato presentato e – oltre che alle croniche difficoltà di governance di tutti i progetti europei – si è, per ora, dovuto arrendere alla constatazione che senza un ecosistema finanziario e tecnologico dell’innovazione paragonabile a quello del Big Tech americano è pressoché impossibile sottrarsi al “colonialismo digitale” degli USA.

E infatti dopo pochi mesi dagli annunci di Altmaier, Gaia-X ha annunciato l’adesione al progetto di Microsoft, Amazon e Google e persino Palantir. In pratica ciò che si cercava di fare uscire dalla porta è rientrato dalla finestra.

Nel frattempo da progetto con obiettivi concreti, negli ultimi due anni, Gaia-X sembra essersi trasformato nell’ (ennesima) fondazione europea orientata a mettere in campo indicazioni di policy più che cabinet di server (i suoi responsabili sostengono che questa sia sempre stata l’intenzione, con buona pace di Altmaier e dell’Airbus).

Il ridimensionamento degli orizzonti di Gaia-X non ha impedito a diversi leader europei di continuare a fare velleitari proclami in merito a imprecisati progetti di “sovranità digitale” che tuttavia spesso si rivelano giganti coi piedi di argilla.

Se si scorrono le dichiarazioni in merito ai temi delle infrastrutture del computing, rilasciate negli ultimi 10/15 anni da politici e commissari europei di turno, si ha la sensazione di vivere in una specie di “giorno della marmotta” in cui, discorso dopo discorso, vengono ripetute pressoché le stesse esatte formule senza che nel frattempo avvenga nulla di rilevante.

La guerra dei chip

La materialità dei centri di calcolo si intreccia con le nuove “guerre” tecnologiche tra Cina e USA, in particolare sui chip, il nucleo atomico dell’infrastruttura del computing.

Come ho scritto nella prima puntata di questa serie: “tutto ciò che di rilevante accade oggi nell’universo della computazione accade nelle due principali dimensioni dello stack: la scala microscopica dei chip e dei transistor e quella macroscopica delle infrastrutture di accumulazione, elaborazione e distribuzione dei dati”. Ciò vale, ovviamente, anche per la geopolitica.

Oggi l’addestramento e lo sviluppo dell’AI dipendono in gran parte dalla disponibilità di grandi quantità di chip avanzati, progettati principalmente da Nvidia ma sempre più anche dalle stesse aziende di hyperscaler.

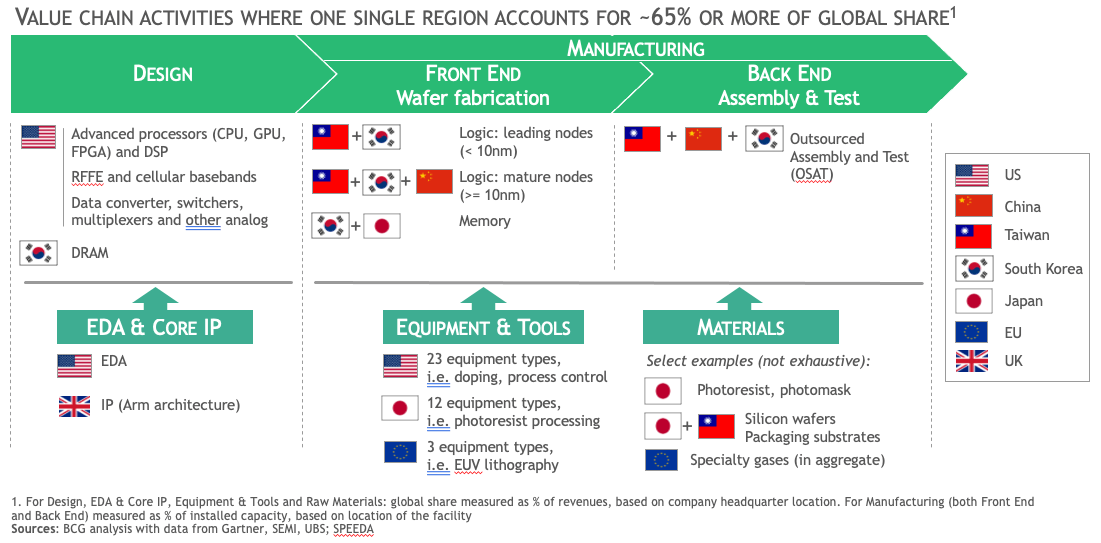

La catena del valore dei chip avanzati è estremamente complessa – al contempo molto distribuita geograficamente e altamente concentrata – e ciò la rende vulnerabile a tensioni geopolitiche e ad ambizioni politiche di controllo.

Da una parte abbiamo infatti un polo dell’innovazione che si trova soprattutto negli Stati Uniti, con aziende come Nvidia, Amd, Qualcomm, Intel (oggi in difficoltà, per ragioni che vedremo nella prossima puntata), e i soliti noti del big tech (Google, Apple etc) che progettano e disegnano i chip più avanzati del mondo e i software per ricavarne il massimo della potenza.

Dall’altra abbiamo un centro della manifattura che, per quanto riguarda i chip destinati alla computazione AI, si concentra quasi interamente a Taiwan e intorno all’azienda TSMC. Nel mezzo c’è una miriade di aziende iper-specializzate in diverse parti del processo, come l’olandese ASML che produce macchinari di fantascientifica complessità per la litografia dei transistor.

Constatato come i chip stiano all’avanzamento dell’AI come la farina a una focaccia, nell’ultimo decennio gli Stati Uniti hanno individuato proprio in questo fondamentale componente, lo snodo da presidiare per rallentare i progressi della Cina nel campo. Prima Obama, quindi Trump e infine (soprattutto) Biden hanno cercato, con diverse modalità, di mettere il bastone tra le ruote allo sviluppo AI cinese proprio partendo dai chip.

Dal 7 ottobre 2022, il Bureau of Industry and Security (BIS), l’ufficio del Dipartimento del Commercio USA che si occupa degli scambi con un potenziale impatto sulla sicurezza americana, ha posto il veto sull’esportazione in Cina di chip avanzati, in particolare quelli utilizzati nei data center per l’AI, ovvero le GPU disegnate da Nvidia e prodotte da TSMC, ma anche le attrezzature per produrre tali chip, incluse quelle di aziende europee come ASML o giapponesi come Nikon.

Come si poteva leggere nella nota di comunicazione che lo accompagnava, il provvedimento mirava a:

“limitare la capacità della Repubblica Popolare Cinese di ottenere e produrre chip avanzati e di sviluppare e mantenere supercomputer. Questi strumenti e competenze sono impiegati dalla Repubblica Popolare Cinese per realizzare sistemi militari incluse armi di distruzione di massa, aumentare la velocità e la precisione nei processi di pianificazione e logistica militare, oltre che nei suoi sistemi di attacco autonomi”.

Il legame tra infrastrutture della computazione e rivalità tra superpotenze, tra AI e sicurezza non poteva essere espresso in modo più esplicito.

Resta tuttavia un problema. E ovvero che le regole non è sufficiente scriverle ma bisogna anche farle rispettare. E infatti sempre nella stessa nota si leggeva: “la capacità del BIS di determinare se una parte rispetta le nostre normative sul controllo delle esportazioni è un principio fondamentale del nostro programma”.

Tra il dire e il fare c’è di mezzo il mare ed è, per esempio, notizia recentissima il ritrovamento di un componente avanzato prodotto da TSMC all’interno di un processore per l’AI del colosso cinese Huwaei.

TSMC ha immediatamente notificato l'accaduto al Dipartimento del Commercio statunitense, sottolineando che dal 2020 non rifornisce direttamente Huawei e che dunque i chip devono essere arrivati fino a lì tramite un sistema di aziende intermediarie e una filiera di scatole cinesi.

Presa per buona la parola di TSMC, la vicenda ha spinto gli americani a riesaminare le proprie misure di controllo e ad inasprire ulteriormente le limitazioni.

Rimane il fatto che questo episodio – come altri seppure meno clamorosi che lo hanno preceduto – evidenzia la complessità del mantenere il controllo sulle catene dell’approvvigionamento tecnologico e lascia più di un dubbio sull’effettiva efficacia delle restrizioni americane sugli hardware.

Tali restrizioni tuttavia raccolgono un consenso bipartisan talmente convinto che si può prevedere che continueranno, insieme a una marea montante di tariffe più “generiche”, anche durante l’amministrazione Trump.

Nel frattempo possiamo dare per certo che nei prossimi anni Cina e USA continueranno a investire centinaia di miliardi per ottenere, nel modo più univoco possibile, la supremazia tecnologica nell’ambito dei chip, delle infrastrutture della computazione e dello sviluppo delle applicazioni AI.

Tuttavia appare sempre più chiaro che la costituzione di filiere del tutto autonome e autosufficienti – tanto nell’ambito “duro” dell’infrastruttura quanto in quello “morbido” della ricerca e del software – sia impresa difficile da districare dalle logiche globali d’interdipendenza dentro cui è nata e cresciuta negli ultimi decenni di relativa “pax commerciale”.

Lo scacco del futuro

Nella politica internazionale contemporanea, l'accesso alle risorse computazionali per l’AI sta diventando un elemento strategico al pari delle risorse energetiche o delle materie prime.

Le grandi potenze hanno quindi iniziato a considerare le infrastrutture computazionali come una nuova frontiera per la proiezione del proprio potere globale, cominciando una “corsa alle armi digitali” che in teoria potrebbe definire i rapporti internazionali dei prossimi decenni.

Ci sono tuttavia alcune variabili da tenere in considerazione. La principale è che il modo in cui le AI vengono addestrate e utilizzate potrebbe cambiare nei prossimi anni. Nuove tecnologie stanno infatti rendendo possibile la decentralizzazione della computazione AI attraverso architetture innovative come la computazione edge e i chip specializzati per il calcolo AI in locale (il cosiddetto on-device AI).

Questi sviluppi favorirebbero l’autonomia di Stati e aziende nello sviluppo di capacità di calcolo AI, riducendo la loro dipendenza dalle piattaforme hyperscaler.

Ciò non avrebbe solo un impatto tecnologico, ma trasformerebbe anche gli equilibri geopolitici in merito. Un futuro senza la dominanza degli hyperscaler potrebbe aprire la strada a un’era di maggiore pluralismo tecnologico che influenzerebbe profondamente i rapporti di potere tecnologico tra Stati.

C’è inoltre la possibilità, spesso trascurata nei conciliaboli su questi temi, che nuove soluzioni emergano non dal versante dell’hardware ma da quello del software e degli algoritmi.

Già oggi, AlphaFold, una delle applicazioni AI più interessanti e utili sul pianeta (tanto da essere stata premiata con l’ultimo Nobel per la chimica) che si occupa dell’analisi della struttura delle proteine, utilizza appena lo 0,003% del potere di computazione richiesto da un “grande modello linguistico” come quelli che utilizza Chat-GPT.

Uno dei motivi è che AlphaFold fa uso di dataset più specifici e ristretti rispetto a un’AI generativa. Ma è possibile ipotizzare che questa specializzazione divenga, in futuro, più comune e diffusa in altri campi, riducendo quindi il carico computazionale richiesto da ogni singolo modello.

La stessa riduzione del carico di computing potrebbe essere ottenuta anche da un miglioramento nell’efficienza degli algoritmi di addestramento e inferenza. Non è quindi detto che sarà sempre e solo la mera “potenza di computazione” la variabile determinante per definire il livello di sviluppo di un sistema AI, rendendo quindi “futili” gli sforzi di controllare la catena del valore dal lato dell’hardware (come fanno oggi gli USA).

È questa una possibilità che anche i decisori europei dovrebbero tenere maggiormente presente. Dato che le scale dei giganti del cloud si sono rivelate inattaccabili, anziché tentare di scalarle probabilmente invano, sarebbe forse più utile provare a capire se esistono modi per aggirarle prima che siano altri a trovarli.

Chi sono e cosa stanno cercando di fare questi “altri” sarà proprio il tema della quarta e ultima puntata di “Stati della computazione”.

Se siete nuovi da queste parti, io mi chiamo Cesare Alemanni. Mi interesso di questioni all’intersezione tra economia e geopolitica, tecnologia e cultura. Per Luiss University Press ho pubblicato La signora delle merci. Dalle caravelle ad Amazon, come la logistica governa il mondo (2023) e Il re invisibile. Storia, economia e sconfinato potere del microchip(2024).