Macro | 💡 Stati della computazione/4 💡

La crisi di Intel e le prospettive sul futuro del calcolo

Benvenuti alla quarta e ultima puntata di “Stati della computazione”, la mini-serie che approfondisce il tema dell’infrastruttura del computing e che esce in contemporanea su Macro e su Appunti di Stefano Feltri. Qui la prima, la seconda e la terza puntata.

Nel corso di “Stati della computazione” ho nominato spesso la “legge di Moore”, ovvero l’osservazione che il numero di transistor per chip – e quindi la loro capacità di calcolo – raddoppia in media ogni due anni. Quello che non ho raccontato forse abbastanza è chi fosse il suo “profeta”, il chimico Gordon Moore (1929 - 2023).

Moore è stato uno dei grandi protagonisti della microelettronica novecentesca. Ha fatto parte dei celebri “traitorous eight”, il gruppo di otto che, a fine anni Cinquanta, abbandonò uno dei padrini dell’intera disciplina, William Shockley – uomo di leggendario narcisismo – per passare a Fairchild Semiconductors, dove nacque a tutti gli effetti la produzione di massa dei chip, e infine co-fondò, insieme a Bob Noyce, un’azienda che è sinonimo di informatica: Intel.

Nata nello stesso anno – il 1968 – in cui milioni di giovani occidentali speravano di cambiare il mondo a colpi di slogan, Intel il mondo lo ha cambiato davvero. Nei suoi 56 anni di vita, l’azienda ha creato quasi da sola il mercato dell’informatica di largo consumo, grazie alla sua capacità di miniaturizzare i transistor e di estendere per decenni la validità della legge di Moore, rendendo in tal modo più economici, maneggevoli e potenti i computer.

Oggi Intel versa tuttavia in uno stato di profonda crisi. Una situazione che si deve a errori specifici dei suoi vertici ma che fa da cartina di tornasole dello “stato della computazione” contemporanea.

Un errore vitale

Le radici della crisi di Intel affondano nella metà degli anni Zero, quando l’allora CEO Paul Otellini disse un clamoroso no all’offerta di Steve Jobs di produrre i chip per un nuovo dispositivo su cui Apple puntava moltissimo: l’iPhone.

Otellini era convinto che non fosse un buon affare. Due miliardi e mezzo di iPhone venduti in nemmeno vent’anni la dicono diversamente e spiegano perché, ancora oggi, il suo niet riecheggi come un anatema tra i corridoi di Intel a Santa Clara.

L’errore di Otellini danneggiò Intel anche indirettamente. L’ascesa degli smartphone infatti non contribuì solo a ridurre le quote di mercato dei PC, i principali “consumatori” di chip Intel, ma plasmò l’intero ecosistema della computazione. Gli smartphone furono infatti il perno decisivo per il successo delle piattaforme e per l’affermazione del cloud computing.

Questa svolta erose ulteriormente la diffusione dei PC e mandò in crisi il mercato dei chip logici (CPU) in cui storicamente Intel era leader grazie alla sua architettura x86, il gold standard del settore.

Negli anni Dieci tale standard venne messo in discussione dai giganti degli smartphone prima e del cloud computing poi. I quali iniziarono a esplorare soluzioni alternative, inclusa la possibilità di sviluppare architetture diverse da quelle di Intel, a partire da matrici fornite dall’inglese ARM Holdings.

Il cambiamento del mercato dell’informatica di largo consumo derivato dall’introduzione degli smartphone, e l’accelerazione che ciò impresse al ritmo dell’innovazione dei chip, resero ancora più vantaggioso lo scorporo dell’industria in due rami che era cominciato già negli anni Ottanta.

Ovvero da una parte aziende “fabless”, che si occupano solo di progettazione (come Nvidia) e dall’altra aziende “foundry”, che si occupano solo di manifattura (come TSMC). Esattamente l’opposto del modello “integrato” di Intel, una delle pochissime aziende IDM (Integrated Device Manufacturer) che ancora svolge entrambe le fasi.

Intel si è trovata così a competere su due fronti contro aziende specializzate solo in uno e ha finito per perdere quote di mercato su entrambi. Anche perché nel frattempo l’emergere del calcolo parallelo per la computazione AI, ha portato a prediligere le famose GPU, chip molto diversi dai chip logici, e in cui Nvidia partiva con un vantaggio tecnologico e di mercato incolmabile (anche per una precedente scelta di Intel di non investire nella tecnologia).

Per anni Intel è riuscita a celare l’entità della crisi ma negli ultimi mesi essa è emersa in modo fragoroso.

L’attuale CEO Pat Gelsinger sta tentando una complessa operazione di salvataggio che punta a dotare Intel di capacità di manifattura per conto terzi paragonabili a quelle di TSMC, così da alimentare un flusso di cassa con cui nutrire la ricerca avanzata su tecnologie particolarmente futuribili. In pratica Intel continuerebbe a fare entrambe le fasi ma scorporandole e usando una per nutrire l’altra.

È una strategia di difficile attuazione (e che sembra già in difficoltà) che il governo americano seguirà con grande attenzione, visto che su Intel ha scommesso molto denaro del CHIPS and Science Act, oltre che importanti commesse per la difesa.

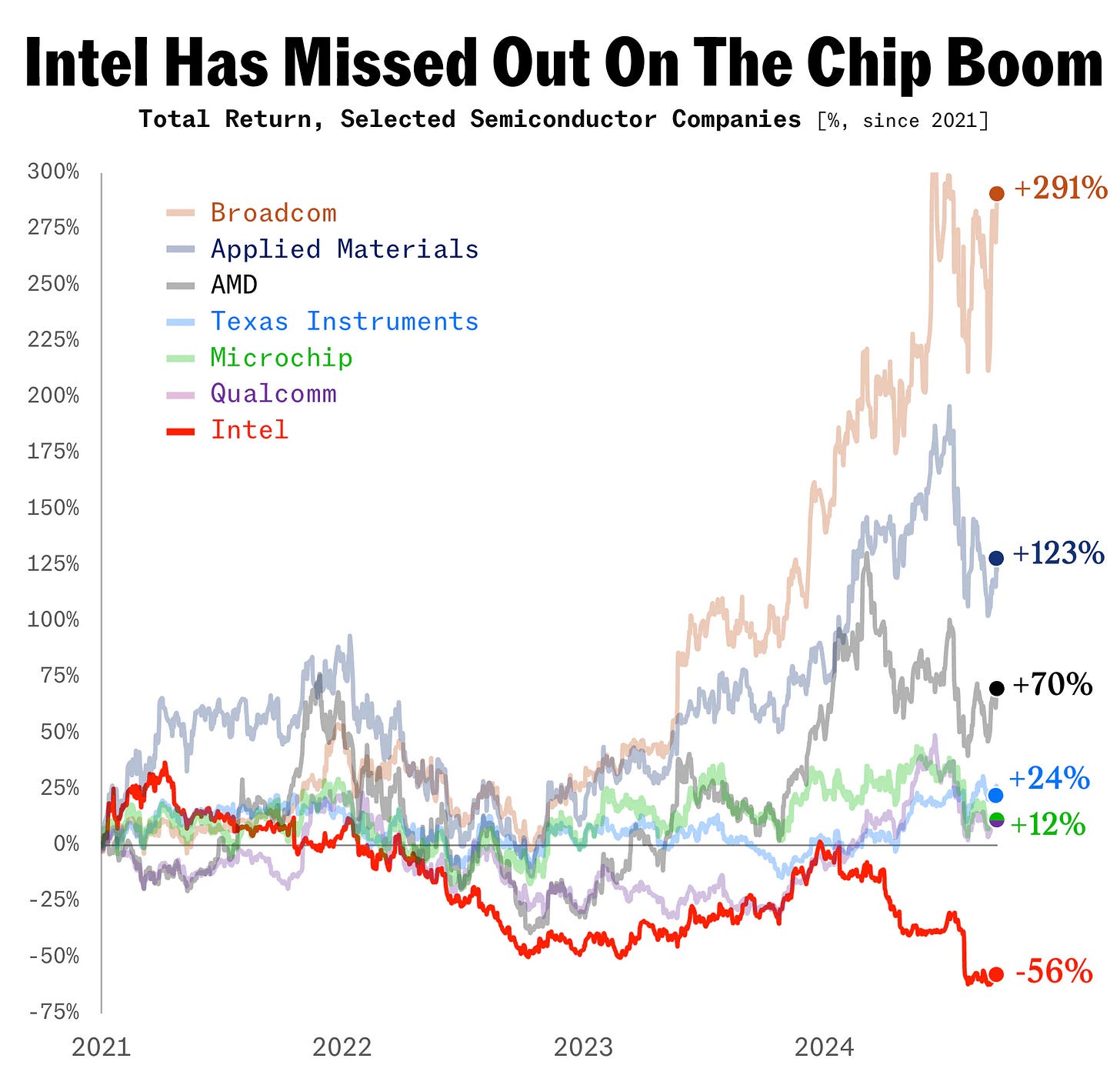

Gli Stati Uniti considerano del resto Intel uno dei loro asset industriali più strategici nonché un pilastro della loro sicurezza tecnologica. Una crisi terminale dell’azienda – che di recente ha cominciato a perdere quote anche nel mercato delle CPU (vedi grafico sotto) – costituirebbe un durissimo colpo alle ambizioni americane di resilienza nell’industria dei semiconduttori.

La lezione di Intel

La vicenda di Intel è un esempio emblematico della rapidità con cui si muove il settore dei chip e di come un singolo cambio di paradigma nello stack della computazione possa travolgere persino aziende che hanno scritto la Storia.

Ciò che oggi vale per Intel potrebbe in futuro valere per gli attuali dominatori del settore, soprattutto se commetteranno errori di valutazione grossolani come quello di Ottolini.

Come si è spesso ripetuto negli articoli precedenti, oggi la computazione (AI e non) è dominata da un lato dai soggetti che ne gestiscono l’infrastruttura “macro” – i cosiddetti hyperscaler come Amazon Web Services, Google Cloud e Microsoft Azure – e dall’altro da quelli che meglio padroneggiano la dimensione “micro” dei transistor, come Nvidia e TSMC.

La computazione è intersecata inoltre da tre grandi crisi del suo (e del nostro) tempo: la crisi energetico-ambientale, la crisi politica del mondo multipolare, e la fine della “legge di Moore”, ovvero la crescente difficoltà, per ragioni di natura fisica, di mantenere costante il raddoppio biennale dei transistor a prezzi accettabili.

È possibile, se non certo, che, in un orizzonte medio-lungo, l’intreccio di questi temi trasformerà gli “stati della computazione” in modi tali da renderli quasi irriconoscibili a chi li osserva oggi.

Vale dunque la pena sintetizzare cosa potrebbe accadere in ognuno degli ambiti (micro e macro) in cui agisce la computazione e con quali effetti sul computing stack e sui suoi protagonisti.

Quantum

Come la rivoluzione industriale stimolò lo sviluppo delle infrastrutture energetiche, rendendolo molto più potenti e capillari, in questa fase diverse forze convergenti – l’espandersi dell’AI, i problemi fisici e geopolitici dei chip e quelli energetici degli hyperscaler – promettono di cambiare la natura profonda del computing.

Il calcolo classico, basato sul transistor e sul silicio, è stato finora il modello dominante. Tuttavia, i suoi limiti sono sempre più evidenti e ciò sta spingendo l’industria della computazione a esplorare nuove soluzioni tecnologiche.

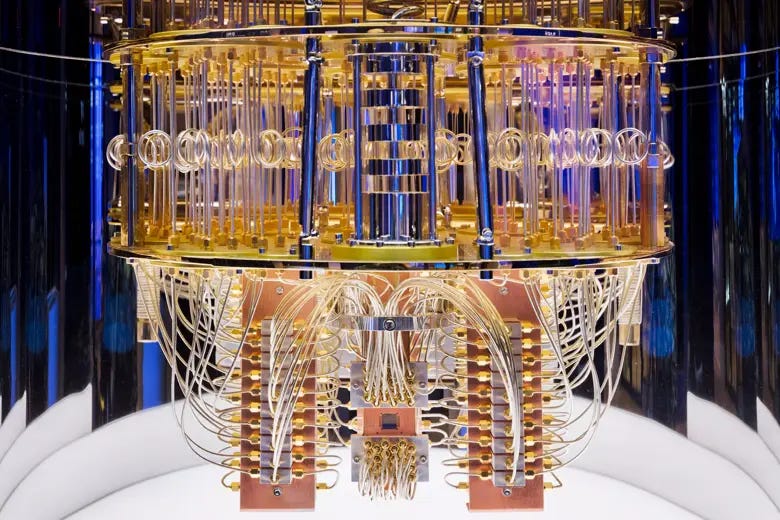

La più estrema, e capace di catturare l’immaginazione , è la computazione quantistica, un paradigma di calcolo che sfrutta i principi della meccanica quantistica, la teoria che descrive il comportamento delle particelle subatomiche.

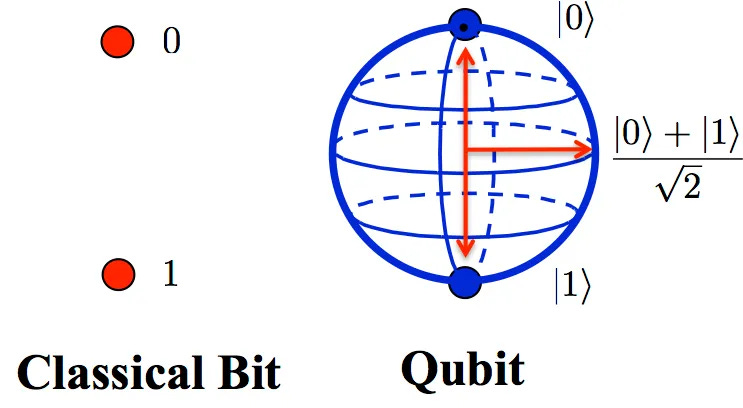

A differenza dei calcolatori tradizionali, che elaborano informazioni utilizzando bit che possono rappresentare uno solo tra due valori (0 e 1) alla volta, i computer quantistici usano qubit (quantum bit), che possono rappresentare contemporaneamente 0, 1, o una combinazione di entrambi.

Due principi fondamentali rendono la computazione quantistica molto potente: la sovrapposizione e l’entanglement.

Grazie alla sovrapposizione, un qubit può esplorare molte soluzioni contemporaneamente, permettendo ai computer quantistici di affrontare problemi complessi in un tempo molto inferiore rispetto ai computer classici.

In virtù dell’entanglement, i qubit si correlano tra loro così che lo stato di uno dipenda da quello dell’altro, anche a grandi distanze.

Quando i qubit sono entangled, un'operazione su uno di essi influenza immediatamente gli altri, consentendo di rappresentare simultaneamente un numero esponenziali di combinazioni di stati, in pratica una versione iper-potenziata del calcolo parallelo che avviene nei chip GPU con cui oggi si addestrano le AI.

Nonostante i suoi vantaggi, l'entanglement è molto sensibile alle interferenze esterne (il cosiddetto quantum noise), un problema noto come decoerenza quantistica. Questo rende difficile mantenere stati stabili per lunghi periodi di tempo, rappresentando una delle principali sfide nella costruzione e nell’utilizzo di computer quantistici.

Non c’è tuttavia dubbio che un’eventuale maturazione della computazione quantistica rappresenterebbe un evento epocale per tutto l’universo della computazione, al punto che non siamo neppure in grado di pronosticarne la portata (e questo è da intendere sia nel senso che potrebbe eccedere le nostre aspettative, che il contrario).

Ciò che invece già sappiamo è che, date le loro caratteristiche, i computer quantistici avrebbero, per esempio, la capacità di violare in pochi minuti (contro le decine di migliaia di anni necessari a un supercomputer tradizionale) tutte le crittografie su cui si basa la sicurezza delle trasmissioni dati a livello globale.

Per questo le principali potenze del pianeta stanno investendo in modo considerevole nel settore, in modo da assicurarsi il cosiddetto “vantaggio quantistico” rispetto agli avversarsi, e la cosiddetta “resistenza quantistica” nei confronti dei loro potenziali attacchi.

In modo simile a quanto avvenuto nei chip avanzati, gli USA si stanno per esempio muovendo da anni per rallentare lo sviluppo del quantum cinese e hanno di recente aumentato i divieti agli investimenti americani in questo settore in Cina.

Di fronte alla continuità di questa frammentazione geopolitica (che al 99,9% proseguirà sotto Trump e oltre) tra sfera di sviluppo tecnologico americano e sfera cinese, è lecito supporre che il futuro della computazione (quantistica o meno, AI e non solo) rifletterà sempre più profondamente questa spartizione a tutti i livelli, con la formazione di un’infrastruttura caratterizzata da protocolli sempre meno globali e compatibili e sempre più mutualmente esclusivi e con capacità limitate di interazione.

Chip sempre più specializzati

Senza arrivare all’estremo del quantum computing (o di prospettive persino più suggestive come la computazione ottica, neuromorfica o il DNA usato come chip di memoria), l’hardware alla base della computazione – il chip – è destinato per forza di cose a cambiare nei prossimi anni.

Con la “legge di Moore” ormai vicina ai suoi limiti fisici, il futuro dei chip non sarà più dettato solo dalla densità dei transistor, ma piuttosto dalla loro specializzazione e da un’integrazione sempre più stretta con i software.

Chip sempre più specializzati come gli acceleratori per l’AI – NPU, TPU e DPU – sono con ogni probabilità solo i precursori di una nuova era di hardware, in cui ogni elemento dell’ecosistema informatico verrà costruito per una specifica tipologia di calcolo.

Questa frammentazione potrebbe condurre a una sorta di “era post-computazionale” in cui i computer universali, capaci di svolgere qualsiasi compito, lasceranno il posto a un insieme di dispositivi ottimizzati per applicazioni individuali.

Il risultato sarà un panorama frammentato, in cui ogni settore industriale potrebbe avere un proprio tipo di chip specializzato: automotive, sanità, telecomunicazioni e difesa etc, ognuno di questi ambiti richiederà hardware personalizzati e interamente progettati in funzione delle loro specifiche esigenze.

Per tenere sotto controllo i costi di produzione di oggetti sempre meno “universali”, una buona strategia potrebbe essere il ricorso ai chiplet, ovvero un nuovo approccio, in stile Lego, alla produzione di semiconduttori, componibili in diverse configurazioni più grandi, da specializzare a seconda delle necessità.

L’azienda che per prima ha esplorato questo settore, Siliconbox di Singapore, ha da poco confermato un investimento da 3,2 miliardi per un impianto di produzione in Italia, nel novarese.

Il ruolo dell’AI e dell’edge computing

L’AI non è solo un prodotto dell’infrastruttura della computazione ma un suo componente ormai sempre più fondamentale.

Se oggi le reti neurali e gli algoritmi di deep learning vengono addestrati su hardware specifici, come le stra-citate GPU, nei prossimi anni queste tecnologie evolveranno per integrare AI che ottimizzino in modo auto-evolutivo le proprie risorse hardware.

I sistemi AI potrebbero insomma non solo interagire con i dati per generare risposte, ma anche per migliorare le proprie stesse architetture e l’uso delle loro risorse, con notevoli effetti di tipo economico, qualitativo ed energetico.

In uno scenario del genere, l’infrastruttura della computazione potrebbe trovarsi a dover affrontare dinamiche molto diverse da quelle attuali.

Produttori di chip e hyperscaler che oggi sembrano dotati di un vantaggio così profondo da non essere più recuperabile si troverebbero a doversi guardare le spalle da competitor con forse meno potenza a disposizione ma con migliori AI per ottimizzarne l’uso (è tuttavia più probabile che i vantaggi si “compongano” e i soggetti con le maggiori risorse siano anche quelli con le migliori AI a disposizione).

Un’altra profonda evoluzione delle dinamiche tecnologiche ed economiche dell’infrastruttura della computazione verrà dalla crescente diffusione dell’edge computing.

Paragonabile metaforicamente a una sorta di filosofia “chilometro 0” applicata alla computazione, l’edge computing è un modello di calcolo distribuito nel quale la computazione avviene il più vicino possibile a dove i dati da elaborare sono stati generati.

Spostando il calcolo più vicino ai dati di origine, si riduce la necessità di trasferire e immagazzinare grandi volumi di informazioni in singoli enormi data center. Ciò porta vantaggi in termini di tempi di elaborazione (particolarmente critici per applicazioni AI come le automobili a guida autonoma e i robot industriali), di volume complessivo del traffico dei dati e di consumi energetici a essi connessi.

Se si dimostrerà più sostenibile, conveniente e scalabile, la diffusione dell’edge computing potrebbe segnare inoltre la fine del modello dominante dei data center centralizzati a favore di infrastrutture più piccole e maggiormente distribuite.

In un simile scenario, persino i colossi oggi inscalfibili del cloud computing e gli hyperscaler dovrebbero evolversi, pena il rischio di finire nella situazione in cui si trova oggi Intel.

Se siete nuovi da queste parti, io mi chiamo Cesare Alemanni. Mi interesso di questioni all’intersezione tra economia e geopolitica, tecnologia e cultura. Per Luiss University Press ho pubblicato La signora delle merci. Dalle caravelle ad Amazon, come la logistica governa il mondo (2023) e Il re invisibile. Storia, economia e sconfinato potere del microchip(2024).

:

Tutta la serie tratta un tema complesso e multidisciplinare in maniera strutturata ed interessante. Leggeró il libro e complimenti per il lavoro divulgativo.

ci capisco poco....